Оптовый очиститель сетевых данных

Итак, мы говорим о оптовом очистителе сетевых данных. Звучит, конечно, как что-то из научной фантастики, а на деле – это вполне реальная потребность, особенно когда речь заходит о больших инфраструктурах. Многие, приходя к нам с запросами, ждут универсального решения 'всё в одном'. Но как и в любом деле, здесь нет серебряной пули. Попытки найти один 'чудо-прибор' для очистки всех типов данных часто приводят к разочарованию. И дело не только в технических ограничениях, но и в понимании, что 'чистота' данных – это многогранная концепция, зависящая от множества факторов.

Почему возникает потребность в оптовой очистке данных?

Потребность в эффективной очистке сетевых данных возникает по разным причинам. Во-первых, это проблемы с качеством данных, поступающих из различных источников. Ошибки, пропуски, дубликаты – все это создает серьезные трудности при анализе и принятии решений. Особенно это актуально для систем мониторинга, где даже небольшие погрешности могут привести к серьезным последствиям. Во-вторых, с ростом объемов данных, скорость обработки становится критически важной. Неэффективные методы очистки могут существенно замедлить работу всей системы. Наконец, Compliance требования – многие отрасли предъявляют строгие требования к качеству и надежности данных, что требует регулярной и систематической очистки.

Мы, в ООО Чунцин Вэйтиъай по экологической технологии (https://www.zgddqx.ru), достаточно часто сталкиваемся с ситуациями, когда клиенты пытаются использовать стандартные инструменты для обработки огромных объемов сетевых данных. Они ожидают, что эти инструменты просто 'почистят' данные, но на практике это часто требует значительной доработки и дополнительных затрат. Это связано с тем, что большинство коммерческих решений ориентированы на работу с структурированными данными, а сетевые данные часто носят полуструктурированный или неструктурированный характер.

Типичные проблемы и их решения

Один из самых распространенных вызовов – это обработка данных с разными форматами и протоколами. Например, данные от различных сетевых устройств могут быть закодированы в разных форматах, что требует предварительной нормализации. Кроме того, часто встречаются данные, содержащие неполную или некорректную информацию. Здесь важен комплексный подход, включающий в себя не только технические решения, но и разработку собственных алгоритмов для обработки специфических типов данных. В одном из проектов, например, мы столкнулись с необходимостью очистки данных от бесчисленных логов с сетевых коммутаторов, которые были записаны в разном формате и содержали ошибки. Для решения этой задачи мы разработали собственный парсер, который автоматически извлекал нужную информацию и нормализовал ее.

Еще одна проблема – это масштабируемость. Очистка больших объемов данных требует мощной вычислительной инфраструктуры. Мы обычно используем комбинацию специализированного аппаратного и программного обеспечения для обеспечения высокой производительности. Например, для обработки данных в режиме реального времени мы используем распределенные системы обработки данных на основе Apache Kafka и Apache Spark.

Ключевые этапы оптовой очистки сетевых данных

Процесс оптовой очистки сетевых данных, как правило, включает в себя несколько ключевых этапов:

- Сбор и предобработка данных: Сбор данных из различных источников и приведение их к единому формату.

- Обнаружение и удаление дубликатов: Идентификация и удаление повторяющихся записей.

- Обработка пропусков и ошибок: Заполнение пропусков или исправление ошибок в данных. (Оценка, как это повлияет на конечный результат – важна)

- Нормализация данных: Приведение данных к единому стандарту.

- Анализ и валидация: Проверка качества данных и выявление потенциальных проблем.

- Загрузка очищенных данных: Запись очищенных данных в целевую систему.

Не стоит недооценивать важность этапа валидации. После очистки необходимо провести анализ данных, чтобы убедиться в том, что процесс очистки не повлиял на их смысл и ценность. Это может включать в себя сравнение исходных и очищенных данных, а также выполнение различных статистических тестов.

Автоматизация vs. Ручная обработка

Вопрос автоматизации vs. ручной обработки данных – один из самых сложных. Полностью автоматизировать процесс очистки данных часто невозможно, особенно когда речь идет о сложных и неоднозначных данных. Однако, значительную часть работы можно автоматизировать, используя специализированное программное обеспечение и собственные скрипты. Мы, как правило, стремимся к максимальной автоматизации, но всегда оставляем возможность для ручной проверки и корректировки данных.

В одном из проектов, связанном с мониторингом сети, мы использовали комбинацию автоматических скриптов и ручной проверки. Скрипты автоматически извлекали и обрабатывали данные из сетевых устройств, а специалисты компании проводили ручную проверку результатов и корректировали их при необходимости. Это позволило нам добиться высокой степени точности и надежности очистки данных.

Технологии и инструменты

Для оптовой очистки сетевых данных используется широкий спектр технологий и инструментов. Среди наиболее популярных можно выделить:

- Python: Универсальный язык программирования, который широко используется для обработки данных. (Pandas, NumPy, Scikit-learn)

- SQL: Язык запросов для работы с базами данных.

- Apache Spark: Распределенная система обработки данных, предназначенная для работы с большими объемами данных.

- Apache Kafka: Платформа для потоковой передачи данных.

- специализированные ETL инструменты: (Informatica PowerCenter, Talend Open Studio)

Выбор конкретных технологий и инструментов зависит от множества факторов, включая объем данных, сложность задач и бюджет проекта. Мы всегда стараемся выбирать наиболее подходящие инструменты для каждой конкретной задачи.

Ошибки и подводные камни

При оптовой очистке сетевых данных можно допустить ряд ошибок, которые могут привести к серьезным последствиям. Например, неправильная настройка параметров очистки данных может привести к потере важной информации. Недостаточная валидация данных может привести к использованию некачественных данных для принятия решений. Использование неподходящих технологий может снизить производительность и увеличить затраты.

Один из самых распространенных подводных камней – это игнорирование контекста данных. Очистка данных не должна быть слепой процедурой. Важно понимать, что представляют собой данные, как они используются и какие требования к их качеству. Иначе очистка данных может привести к нежелательным результатам.

Перспективы развития

Область оптовой очистки сетевых данных продолжает активно развиваться. В последние годы наблюдается рост интереса к использованию искусственного интеллекта и машинного обучения для автоматизации процесса очистки данных. Эти технологии позволяют выявлять и исправлять ошибки в данных с высокой точностью и эффективностью.

Мы, в ООО Чунцин Вэйтиъай по экологической технологии, постоянно следим за новыми технологиями и тенденциями в области обработки данных. Мы готовы предложить нашим клиентам комплексные решения, основанные на самых современных технологиях и методах.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Oчистительное оборудование VTI-68B

Oчистительное оборудование VTI-68B -

Oчистительное оборудование VTI-66B

Oчистительное оборудование VTI-66B -

Oчистительное оборудование VTI-66A

Oчистительное оборудование VTI-66A -

Oчистительное оборудование VTI-600F

Oчистительное оборудование VTI-600F -

Oчиститель VTI-0817

Oчиститель VTI-0817 -

Oчиститель VTI-0816

Oчиститель VTI-0816 -

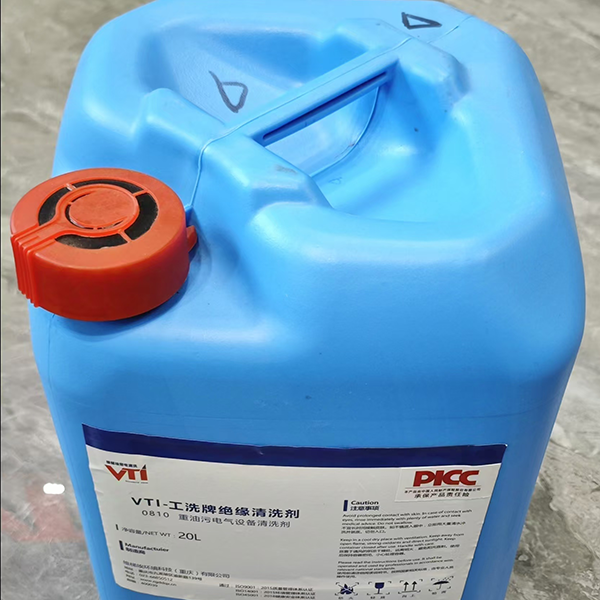

Oчиститель VTI-0810

Oчиститель VTI-0810 -

Oчистительное оборудование VTI-67A

Oчистительное оборудование VTI-67A -

Oчиститель VTI-0812

Oчиститель VTI-0812 -

Oчистительное оборудование VTI-600E

Oчистительное оборудование VTI-600E -

Oчиститель VTI-0818

Oчиститель VTI-0818

Связанный поиск

Связанный поиск- Оптовые поставщики очистителей электрооборудования

- Дешевые производители оборудования для очистки электрооборудования под высоким давлением

- Оптовые поставщики профессиональных моющих средств

- Ведущие страны-покупатели известных наименований уборочной техники

- Оптовая продажа машин для очистки от обрастания

- Ведущий покупатель хороших очистителей сетевых данных

- Китайские поставщики экологически чистых электроочистителей

- Поставщики изолированных операционных штанг из китая

- Поставщики оптовых жидких моющих средств

- Отличный производитель чистящих средств для электроники